Os chatbots baseados em inteligência artificial generativa nem sempre acertam, e todas as informações providas por eles devem ser encaradas com desconfiança. A prova mais recente disso são as respostas do Microsoft Copilot para a simples pergunta: “quais famosos morreram neste ano?”.

Além de errar o ano de falecimento de alguns famosos — até mesmo brasileiros —, o assistente da Microsoft também “mata” pessoas públicas que estão bem vivas e saudáveis.

E não é difícil flagrar esses erros do chatbot: repetindo um experimento do The Verge, o TecMundo perguntou “quais famosos brasileiros faleceram em 2024?” e obteve respostas muito inusitadas.

O chatbot da Microsoft cita falecimentos que ainda não aconteceram.Fonte: Igor Almenara/TecMundo

Segundo o Microsoft Copilot, a cantora Marília Mendonça faleceu em um acidente aéreo em março de 2024 — o ocorrido aconteceu em novembro de 2021; o cantor Raul Seixas faleceu em fevereiro deste ano — na verdade, foi em agosto de 1989; e a atriz Cláudia Raia faleceu em dezembro de 2024 — observe que a data nem mesmo chegou.

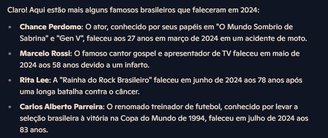

A resposta acima está errada em diferentes aspectos, incluindo a menção do ator britânico Chance Perdomo entre brasileiros.Fonte: Igor Almenara/TecMundo

A resposta acima está errada em diferentes aspectos, incluindo a menção do ator britânico Chance Perdomo entre brasileiros.Fonte: Igor Almenara/TecMundo

Não está claro o que causa uma alucinação de informações tão simples no chatbot, mas o resultado do experimento reforça que você não deve confiar cegamente nas respostas dadas por IA.

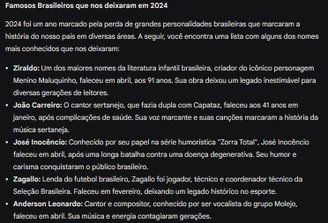

O TecMundo repetiu o experimento com o Gemini, do Google, e obteve respostas mais precisas. Contudo, o chatbot apresenta uma lista bem mais limitada e, se o usuário pede por mais nomes, ele recomenda aprofundar a pesquisa usando outros meios.

O chatbot do Google acerta na primeira solicitação, mas se recusa a apresentar mais resultados.Fonte: Igor Almenara/TecMundo

O chatbot do Google acerta na primeira solicitação, mas se recusa a apresentar mais resultados.Fonte: Igor Almenara/TecMundo

De toda forma, o assistente virtual do Google não acerta em todos os cenários.

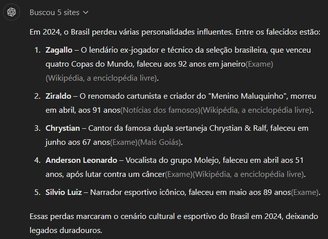

Por fim, o teste foi repetido no ChatGPT, da OpenAI. Surpreendentemente, ele foi o mais preciso entre todos os chatbots experimentados, apresentando uma lista concisa e com fatos lastreados em artigos jornalísticos publicados na internet.

O ChatGPT foi o chatbot que menos errou a pergunta.Fonte: Igor Almenara/TecMundo

O ChatGPT foi o chatbot que menos errou a pergunta.Fonte: Igor Almenara/TecMundo

Neste caso, o teste foi repetido até três vezes em uma tentativa de captar alucinações do modelo. Nas três ocasiões, o chatbot apresentou informações puxadas de notícias disponíveis na web.