A Meta anunciou na última sexta-feira (5) que vai rotular conteúdos gerados por inteligência artificial postados por usuários no Facebook, Instagram e Threads. A medida, que entrará em vigor a partir de maio, segue uma recomendação do Conselho de Supervisão da gigante da tecnologia, atualizando sua política de mídia manipulada criada em 2020.

De acordo com a empresa, áudios, fotos e vídeos gerados por ferramentas baseadas em IA irão receber os rótulos. A identificação destes materiais acontecerá quando os próprios usuários informarem que recorreram à tecnologia ou se as redes sociais detectarem “indicadores de imagem de IA conforme as normas da indústria”.

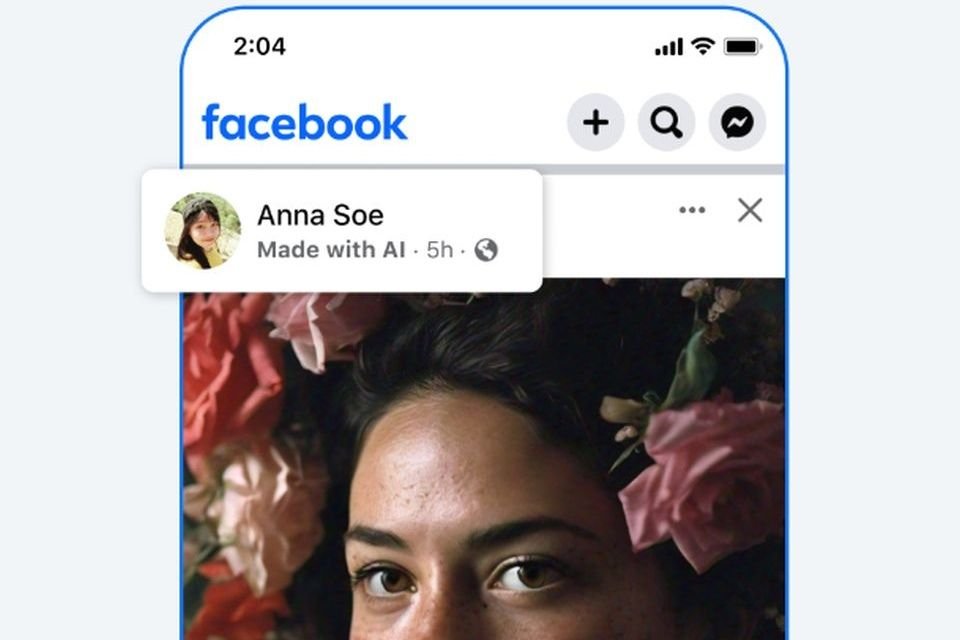

Rótulo identificando conteúdo feito por IA no Instagram.Fonte: Meta/Divulgação

O funcionamento deste sistema de detecção não foi detalhado pela companhia, que afirmou possuir uma rede de quase 100 verificadores de fatos independentes. Eles são responsáveis pela revisão de “conteúdos falsos e enganosos” criados por IA, atuando no combate à desinformação nas redes sociais do conglomerado.

Com a mudança, os conteúdos gerados por IA receberão o selo “Made with IA” ou “Feito com IA”, em tradução livre. Caso a Meta considere que o material tenha um potencial maior de enganar o público sobre uma questão relevante, o rótulo pode vir acompanhado de informações para contextualizá-lo.

Remoção de conteúdos gerados por IA

A atualização nas políticas da Meta para conteúdos manipulados evitará que tais materiais postados no Instagram, Facebook e Threads sejam restringidos, como acontece atualmente. Como informado acima, a empresa poderá adicionar contexto em determinadas postagens para educar os usuários, se necessário.

De acordo com a big tech, isso evita o “risco de restringir sem necessidade a liberdade de expressão”. Vale destacar que a empresa já realiza a rotulagem de imagens fotorrealistas feitas com sua ferramenta de IA própria, adicionando o selo “Imagined with AI”.

No entanto, a vice-presidente de política de conteúdo da Meta, Monika Bickert, ressaltou que a remoção de conteúdos que violem as diretrizes da comunidade segue inalterada. Ou seja, os materiais podem ser excluídos se não cumprirem as normas sobre intimidação, interferência eleitoral e assédio, independente de terem sido criados por humanos ou bots.